科大讯飞再获第一,汽车自动驾驶领域技术实现新突破!

近日,科大讯飞AI研究院在目前最权威的nuScenes自动驾驶评测比赛上,取得纯视觉3D目标检测任务的冠军。该技术的突破,为讯飞在自动驾驶领域产品布局打下坚实的技术基础,让自动驾驶行业往“更安全、更智能”的目标更近一步。

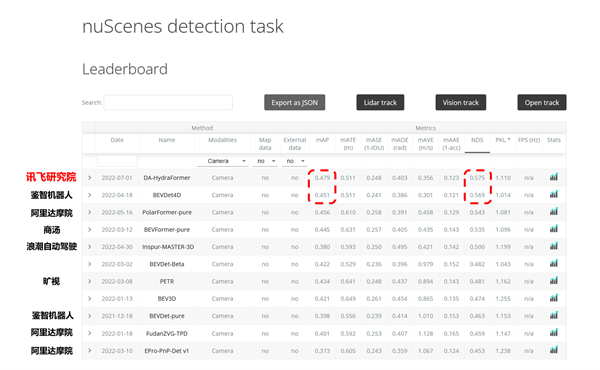

(比赛排行榜)

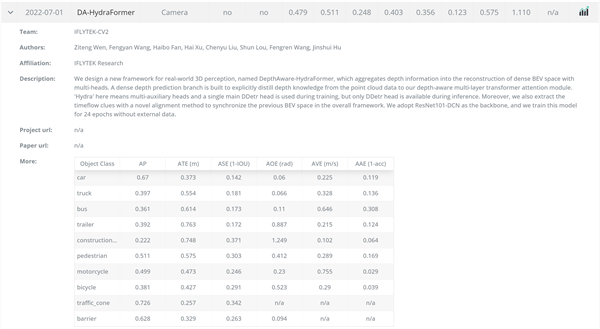

(比赛结果)

nuScenes数据集是由知名无人驾驶技术公司Motional公司建立的大规模自动驾驶数据集。它拥有目前最完善的传感器配置,包含一个激光雷达,五个毫米波雷达,六个相机,IMU和GPS。nuScenes数据采集于多个城市1000 个场景,并提供了二维、三维物体标注、点云分割、高精地图等丰富的标注信息、总共多达140 万帧图像、39 万帧激光雷达点云数据、23 个物体类别、140 万个三维标注框。完善的传感器数据和充足的数据量使得nuScenes数据集成为自动驾驶领域中使用最广泛的公开数据集之一,也是目前最权威的自动驾驶3D目标检测评测集。

此次,科大讯飞参加的nuScenes纯视觉3D目标检测赛道(vision track),与其他仅提供部分视角的自动驾驶数据集 KITTI 和 Waymo不同。它提供了 360 度的环视相机视野,可以对周围环境进行全方位的感知。因此自公开以来吸引了来自全球各地的研究团队,不仅有百度、华为、商汤、旷视等知名企业,还涵盖了MIT、清华大学、香港科技大学、上海交通大学、中国科学技术大学等国内外重点高校,可谓百舸争流。

什么是纯视觉?

激光雷达和毫米波雷达等都是现如今自动驾驶领域最常用的感知设备。但激光雷达体积大、费用不菲,毫米波雷达纵向测高能力不足,都存在一定的短板。

所谓纯视觉,就是在不使用激光雷达、毫米波雷达等额外的传感器信息条件下,仅使用6个摄像头完成车外360度的3D目标检测任务。

什么是3D目标检测?

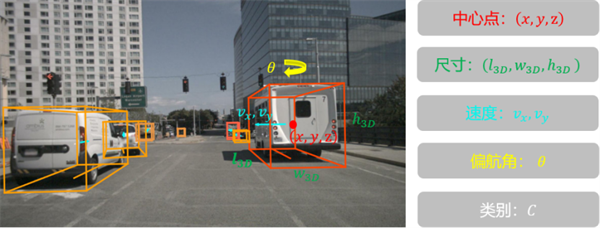

3D目标检测,即不仅需要检测到汽车360度的所有汽车、行人等若干类对象,还要精确感知到他们在真实物理世界中的位置、大小、偏航角、速度等信息。

伴随着深度学习浪潮从 2D 图像席卷至更高维度、更为广泛的数据模态,3D物体检测作为现实应用场景(无人驾驶、机器人、虚拟现实)感知任务中极其重要的一环,已被越来越多的研究人员所关注。在这一波浪潮中,最早取得成功和广泛现实影响力的当属基于LiDAR点云的检测方案。与此同时,也有一批学者正在研究一个更为困难的任务——基于2D图像去做更高维度(2D→3D)的感知任务,如基于单目、双目和多视角的视觉解决方案,实现对空间内各物体的更精准感知。

3D检测任务的难点在哪里?

“真实”是纯视觉3D检测任务需要完成的最重要目标!如上图所示,3D目标检测主要难点不仅是需要输出更多的物体正常物理属性(三维中心点、长宽高、偏航角、速度等),更重要的是其感知回归的是3D场景下物体的真实尺度,而非在2D图像中的拍摄尺度。

我们习惯于通过2D图像去感知3D世界,我们其实就是这样来感知环境的,眼睛里看到的每一帧2D图像,通过远近、高低和阴影等信息,构建了我们对三维立体世界的基础认知。但这一做法从科学上来说,是反常理的,二维信息终究是二维信息,当提取出来的深度信息不准确时,一切的三维感知任务都会变得异常困难。

基于“深度敏感注意力机制”的“九头蛇”Transformer模型(DA-HydraFormer)

针对以上难点问题,科大讯飞AI研究院创新提出了基于“深度敏感注意力机制”的“九头蛇”Transformer模型(Depth Aware Hydra Transformer, DA-HydraFormer)。

在多视角视觉输入统一转换到BEV(Bird Eye View)特征空间这一技术框架的基础上,我们发现现有方案在使用注意力机制聚合特征时,没有直接考虑场景中物体相互遮挡的影响, 提出了深度敏感注意力机制,得到了更鲁棒更精确的BEV特征。

方案整体上有四大核心技术突破:

一、更有效的点云信息蒸馏:针对现有方案深度信息难以学习和建模的问题,提出了稀疏点云信息指导深度敏感注意力机制训练,巧妙地将点云的深度信息蒸馏至BEV Encoder中;

二、更鲁棒的BEV特征聚合:针对多视角2D视觉输入与3D物理空间对齐较难的问题,在现有BEV特征聚合方案的基础上,提出3D目标检测与2D目标检测融合的建模框架,使得模型能够结合视觉语义得到更鲁棒的BEV表征;

三、更精细的时序特征对齐:针对驾驶场景中自车运动所带来的时空信息错位问题,提出使用融合自车运动和位姿变化的动力学方程抵消信息错位,使得模型能够端到端学习到更精细的时序特征;

四、更强大的统一建模形式:针对驾驶场景的视角输入多、尺度跨越大、任务类型广的特点, 我们设计了前端CNN结合中后端Transformer的统一建模方案,结构简单、训练高效、场景通用。

先放几张结果图↓↓

左:雷达BEV视角(鸟瞰图) 右:360°环视相机视角下的检测结果。

(普通城市场景)

(十字路口复杂道路场景)

科大讯飞AI研究院通过基于“深度敏感注意力机制”的“九头蛇”Transformer模型,实现了自动驾驶汽车对周围物体的动态3D深度感知,让车辆对周围环境的敏感度提升,有助于提高自动驾驶车辆和人员的安全性,为讯飞在自动驾驶领域产品布局打下坚实的技术基础。

科大讯飞深耕智能汽车行业19年,目前已形成近1000人的专业团队,实现在汽车智能化和数字化领域的全面产品布局,产品涵盖智能交互、智能座舱、智能音效、自动驾驶、AI销服等。截至2022年3月底,讯飞汽车智能化产品合作已覆盖90%以上的中国主流自主品牌和合资品牌车厂,车型项目交付超过1200个,累计前装搭载量突破3900万。

凭借与众多车企的密切合作关系,强大的研发及交付实力,以及相关人工智能技术优势可与自动驾驶产品研发无缝衔接,科大讯飞现已形成智慧汽车方面较全面的品牌、技术和产品体验完整生态,在自动驾驶和智能汽车领域,占领一席之地。“用人工智能建设美好世界”的品牌愿景也正在一步步实现。

登录

登录 欧盟中国商会金融工作组与高伟绅律师事务所在卢森堡联合举办“欧盟银行业监管动态专题圆桌会”

欧盟中国商会金融工作组与高伟绅律师事务所在卢森堡联合举办“欧盟银行业监管动态专题圆桌会” 应对时代挑战:中欧商界领袖领导力新范式——2024第十届中欧“欧洲论坛”在布鲁塞尔和上海双城连线举办

应对时代挑战:中欧商界领袖领导力新范式——2024第十届中欧“欧洲论坛”在布鲁塞尔和上海双城连线举办