2021第一冠!科大讯飞获国际说话人角色分离比赛DIHARD-3冠军

1月23日,科大讯飞在最新一届国际说话人角色分离比赛(DIHARD-3)中摘得桂冠,让机器在复杂环境下辨别说话人角色的能力进一步提升,这也是国内首次有团队在该赛事上取得冠军。

今天我们就来聊聊这背后的机器“辨”声技术——说话人角色分离技术。

“困难的”说话人角色分离任务

DIHARD,作为该领域最“困难的”挑战赛,由著名的语言数据联盟(LDC)于2018年发起,本次是第三届,也是首次由美国国家标准与技术研究院(NIST)参与联合主办,大大提升了比赛的权威性和影响力。

在DIHARD-3中,比赛数据集合收集了电话、就医、采访、辩论、会议、室外聚会等多个应用场景的真实数据,其难点体现在以下几个方面:

“难”在人多:说话人数量不确定,1~10人不等;

“难”在口杂:多人语音交叠,且对话风格随意;

“难”在干扰:远场混响和噪声等真实环境干扰;

“难”在考核:评价指标严苛,说话人边界容忍度为0。

比赛共有两种任务类型:

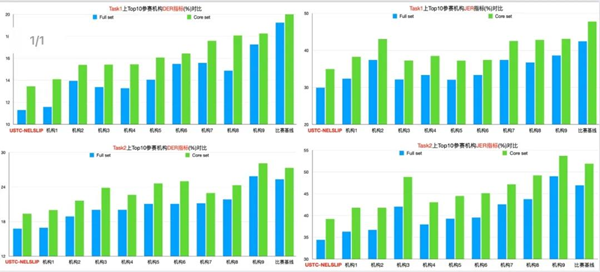

给定官方语音边界(Task1)和不指定语音边界(Task2)。比赛测试集按照场景数据量大小分为两类,即:核心测试集(Core,各场景均衡分布)和完整测试集(Full,各场景非均衡分布)。性能评价指标分别为DER(角色分离总时长错误率)和JER(平均角色错误率)。

DIHARD系列赛持续吸引了国内外一流的研究机构,包括约翰霍普金斯大学、布尔诺理工大学、昆山杜克大学、南加州大学、牛津大学等顶尖团队。科大讯飞联合中国科大语音及语言信息处理国家工程实验室杜俊副教授团队(USTC-NELSLIP)在四个任务排行榜上包揽所有指标第一名,摘得桂冠。

科大讯飞夺得DIHARD-3冠军(Task1,2:JER,DER指标)

科大讯飞夺得DIHARD-3冠军(Task1,2:JER,DER指标)

【注释】DER:Diarization Error Rate : 说话人分离错误率,分离错误的时长占总体有效语音时长的百分比;JER: Jaccard Error Rate: 雅卡尔错误率,所有单个说话人分离错误率的平均。

我们如何让机器如何“辨”声

那么回到最初讨论的话题,机器要怎样才能学会这项本领呢?

传统角色分离系统主要为基于说话人向量的聚类算法,处理过程主要由语音切片、说话人向量提取、聚类等步骤构成,在说话人数量少,且无重叠语音等简单场景下,能够取得较好的效果。然而,在复杂多样的DIHARD数据中,重叠语音段的角色分离问题,作为传统聚类方法的痛点,始终无法被有效处理,这就要求参赛机构提出新的解决方案。

针对该问题,我们重新梳理了技术路线,提出了多种解决思路来代替传统方案:

创新性地将说话人角色分离问题当做语音分离问题来解决,使用端到端语音分离模型,直接处理混合语音,将不同角色的语音信号分开,避免了重叠语音段的检测和标记问题。

将角色标签的指派问题,转化为目标说话人的语音检测问题。利用通过传统聚类方法(或语音分离方法)得到的说话人角色先验,绑定语音检测模型后,直接对每个单独说话人进行存在概率估计,使得每个说话人均能被精准地针对性处理。

创新性提出迭代式说话人估计算法。相比于直接给出估计结果,该策略针对每个角色目标,结合上述各种方法,不断提取说话人角色特性,并优化当前模型。最终建立起多层次多阶段的处理方法,使得系统能够逐渐地建立起对当前会话中每个说话人的感知能力。

最终,所提交系统在复杂场景数据上展现出了较好的鲁棒性,大幅提升了整体角色分离的性能,在比赛的所有数据集合、所有指标下均斩获第一名的好成绩。

目前,讯飞智能录音笔多个系列都已搭载了这项技术,在多人会话场景中,可根据说话人的语音语调自动在文本中区分不同说话人。在录音实时转写的过程中或者转写之后进行智能整理时,都可以开启“区分说话人”这一功能,系统会在结果中进行自动标记区分。

登录

登录 欧盟中国商会金融工作组与高伟绅律师事务所在卢森堡联合举办“欧盟银行业监管动态专题圆桌会”

欧盟中国商会金融工作组与高伟绅律师事务所在卢森堡联合举办“欧盟银行业监管动态专题圆桌会” 应对时代挑战:中欧商界领袖领导力新范式——2024第十届中欧“欧洲论坛”在布鲁塞尔和上海双城连线举办

应对时代挑战:中欧商界领袖领导力新范式——2024第十届中欧“欧洲论坛”在布鲁塞尔和上海双城连线举办